◎ 112年度計畫團隊技術組

生成式AI是一種人工智慧技術,主要特點是能夠生成新的內容,例如文字、圖像或音訊,來解決問題,而不僅僅是對現有資料去進行分類或預測。人工智慧技術有很多種類型,常見的包含監督式學習、非監督式學習、增強式學習等等。我們告訴模型一些範例資料和答案,模型學到資料和答案之間具有鑑別力的特徵後,就可以依樣畫葫蘆去進行分類或預測,這就是監督式學習;非監督式學習,就像是給模型一批資料但不告訴他答案,讓模型自己找到資料當中重要的特徵進行分群;另一種則是我們不給模型訓練資料,但告訴他目標是什麼以及獎勵機制是什麼(怎麼做會得分、怎麼做會扣分),讓模型自行嘗試找出達到高分的方法,這就是增強式學習。生成式AI則強調用更大量的資料,在沒有明確標籤或指導下,學習這些資料的分佈,生成更多類似的資料。

生成式AI所依靠的其中一個技術便是「大型語言模型」(Large Language Model, LLM),特色在於訓練過程中,模型可以從這些大量資料中,自行學習和理解每個詞、每個句子之間的關係與背後的意義,最後,模型便可以根據指令,提供符合邏輯的自然語言回應。好比文字接龍,在提出問題後,大型語言模型會評估在問題背後最高機率會出現的字是什麼,然後一字一字生成出來。

相較於傳統的自然語言處理技術,大型語言模型的優勢有三:

(1)上下文理解:大型語言模型能更好地理解和處理文意,生成的回應更連貫且有邏輯。

(2)多任務適用:大型語言模型能夠應付多種自然語言處理的任務,不需要單獨為每種任務來設計特定的模 型,讓模型的應用更多更廣。

(3)大規模資料:大型語言模型用以訓練的文本資料通常十分龐大,可能是幾千萬甚至幾億的語料。透過這麼大規模的資料來做學習,讓模型能夠掌握更豐富的知識,做出更準確的理解與回覆。

在生成式AI應用上,常見的應用包含智能客服、文案生成創作、資料自動化解讀分析等等,藉由大型語言模型來達到作業自動化,提高工作效率。

不過,從2023年劍橋字典選出的年度代表字:Hallucination,幻想,其實就反應了AI的可信賴性是一大挑戰,因為生成式AI對於沒看過的資訊會想辦法拼湊出答案。模型生成的內容可能表面上看起來合理,實際上卻缺乏真實的參考來源,這種現象在回答專業知識問題時更為明顯,因為模型可能傾向根據模型在訓練數據中學到的資料來生成答案,而非真正理解問題及實際參考文章來進行答覆。

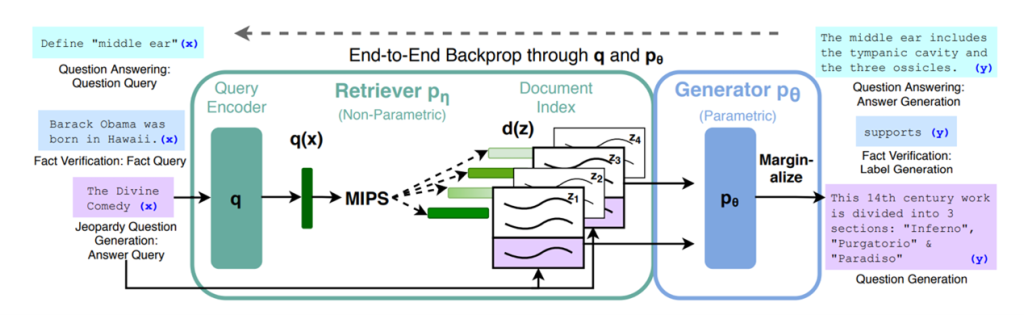

為了解決上述問題,檢索增強生成(Retrieval-Augmented Generation, RAG)技術方法是一個良好的解決方案。RAG是2020年由Patrick Lewis提出,此技術結合檢索和生成式AI的優點,用於使用外部來源獲取的事實來提高生成式AI模型的準確性和可靠性。透過檢索並獲取資料庫中的資訊,再進行答案的生成,以增強回覆的相關性,進一步提升問答效果,確保符合實際應用的需求,減少憑空杜撰的可能性。

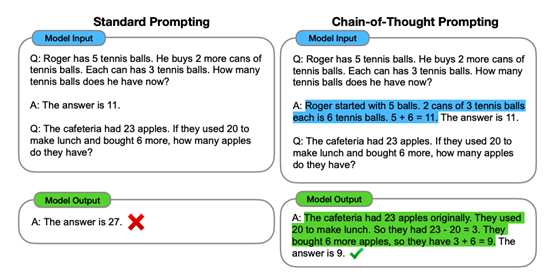

除了RAG,根據2022年1月Google研究員Jason Wei提出的思維鏈(Chain-of-Thought, CoT)概念,在大型語言模型的輸入中加入了一些閒言碎語,將例子加到當前樣本輸入之前,讓模型一次輸入這些文本進行輸出完成任務,能夠使得模型引入更多的思考過程,引導模型進行更深入的推理,透過預測「思維過程」來提高模型的性能,因此可以讓大型語言模型能夠更好地理解並回答複雜的問題。

參考文獻

Wei, J., Wang, X., Schuurmans, D., Bosma, M., Xia, F., Chi, E., … & Zhou, D. (2022). Chain-of-thought prompting elicits reasoning in large language models. Advances in Neural Information Processing Systems, 35, 24824-24837.

Lewis, P., Perez, E., Piktus, A., Petroni, F., Karpukhin, V., Goyal, N., … & Kiela, D. (2020). Retrieval-augmented generation for knowledge-intensive nlp tasks. Advances in Neural Information Processing Systems, 33, 9459-9474.